Des chercheurs alertent sur l'utilisation de l'IA générative pour échapper à la détection des logiciels malveillants

OpenAI elle-même a bloqué plus de 20 réseaux malveillants qui cherchaient à exploiter sa plateforme

- 25 décembre 2024

- Mise à jour: 12 juin 2025 à 09:18

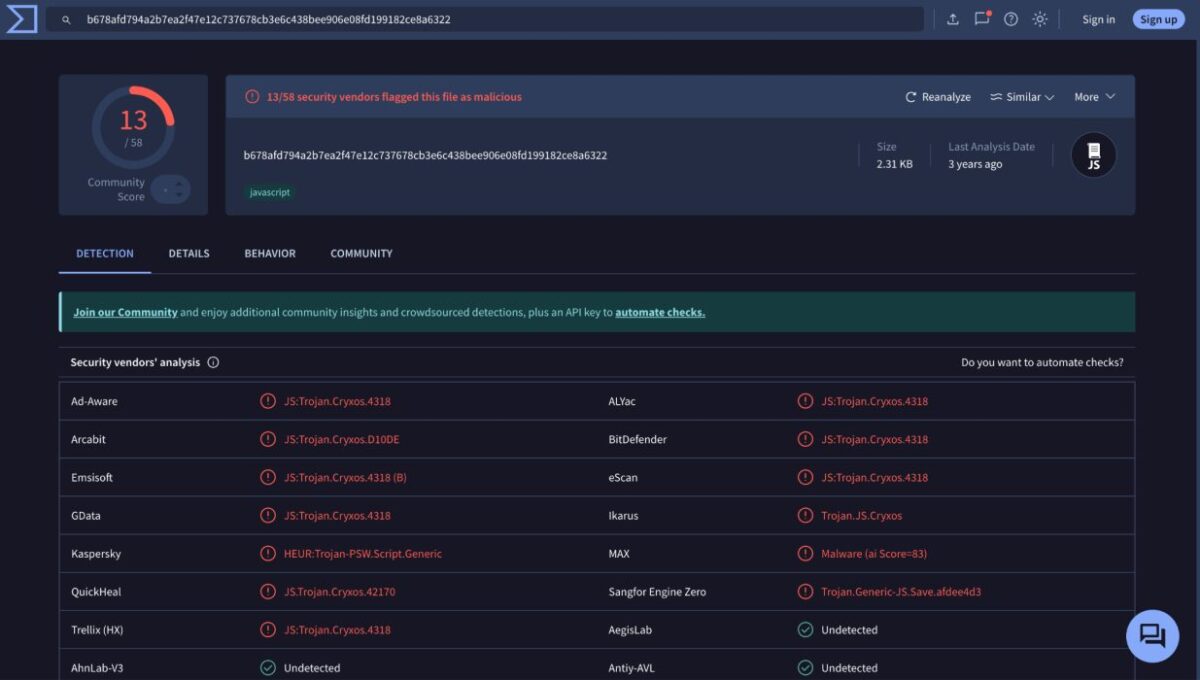

Une analyse récente de Unit 42, de Palo Alto Networks, a révélé que les modèles de langage comme ChatGPT peuvent être utilisés pour modifier des logiciels malveillants en JavaScript, les rendant plus difficiles à détecter. Bien que ces modèles ne génèrent pas de logiciels malveillants à partir de zéro, les cybercriminels peuvent leur demander de réécrire ou d’obfusquer du code malveillant existant. « Ces transformations sont plus naturelles, ce qui complique l’identification des logiciels malveillants », affirment les experts en cybersécurité. Cette approche pourrait dégrader les systèmes de classification des logiciels malveillants en les confondant pour qu’ils étiquettent le code malveillant comme inoffensif.

Abonnez-vous à la Newsletter de Softonic et recevez les dernières nouvelles en tech, jeux, divertissement dans votre boîte mail

Abonnez-vous (c'est GRATUIT) ►Malgré les restrictions de sécurité mises en place par des fournisseurs comme OpenAI, des outils tels que WormGPT sont utilisés pour créer des courriels de phishing plus convaincants et de nouveaux types de logiciels malveillants. En octobre 2024, OpenAI a bloqué plus de 20 réseaux malveillants cherchant à exploiter sa plateforme. Lors de tests, Unit 42 a réussi à générer 10 000 variantes de JavaScript malveillant, en maintenant leur fonctionnalité, mais en diminuant leurs scores de détection dans des modèles comme Innocent Until Proven Guilty. Parmi les techniques utilisées figurent des changements de noms de variables, l’insertion de code inutile et la réécriture complète du script.

De plus, les algorithmes d’apprentissage automatique peuvent être trompés pour classer ces variantes comme bénignes dans 88 % des cas, selon Unit 42. Même les outils les plus populaires, comme VirusTotal, ont des difficultés à détecter ces codes. Les chercheurs avertissent que ces réécritures basées sur l’IA sont plus difficiles à suivre que celles générées par des bibliothèques comme obfuscator.io. Cependant, ils suggèrent que ces mêmes techniques pourraient améliorer les modèles de détection en générant des données d’entraînement plus robustes.

Sur un autre front, des chercheurs de l’Université d’État de Caroline du Nord ont découvert une attaque appelée TPUXtract, qui permet de voler des modèles d’IA exécutés sur les TPUs Edge de Google via des signaux électromagnétiques. Cela dit, bien que la technique se distingue par sa précision, elle nécessite un accès physique à l’appareil et un équipement spécialisé, ce qui limite heureusement sa portée.

De plus, Morphisec a démontré que le système Exploit Prediction Scoring System (EPSS), utilisé pour évaluer les vulnérabilités, peut être manipulé avec des publications fausses sur les réseaux sociaux et des dépôts vides sur GitHub. Selon Ido Ikar, cette technique permet « d’inflater les indicateurs » et de tromper les organisations en modifiant les priorités de gestion des risques cybernétiques.

Publicitaire et producteur audiovisuel passionné par les réseaux sociaux. Je passe plus de temps à penser aux jeux vidéo auxquels je jouerai qu'à y jouer.

Nouveautés de Pedro Domínguez

- WhatsApp collabore avec Google pour que tu puisses découvrir la provenance de n'importe quelle image qu'on te transmet

- L'IA arrivera bientôt dans les applications de rencontres

- Ils découvrent comment se sont formés les objets les plus glacés du système solaire

- L'USB-C est désormais obligatoire sur tous les appareils électroniques dans l'UE : qu'est-ce que cela signifie ?

Vous aimerez aussi

- Infos

Le film Minecraft arrive sur Max, et nous connaissons déjà sa date de sortie

Lire la suite

- Infos

Après s'être battus pour cela, les fans y sont parvenus et Dying Light: The Beast les a entendus

Lire la suite

- Infos

Ce jeu a enthousiasmé et a vendu plus de trois millions d'exemplaires en seulement trois jours

Lire la suite

- Infos

Star Trek: Strange New Worlds lance sa troisième saison, mais certaines idées créatives sont restées en chemin

Lire la suite

- Infos

Regarde la transformation impressionnante de Minecraft avec cette mise à jour

Lire la suite

- Infos

Il a participé à l'une des séries les plus emblématiques de la télévision, et il a également dû se battre pour l'égalité salariale

Lire la suite